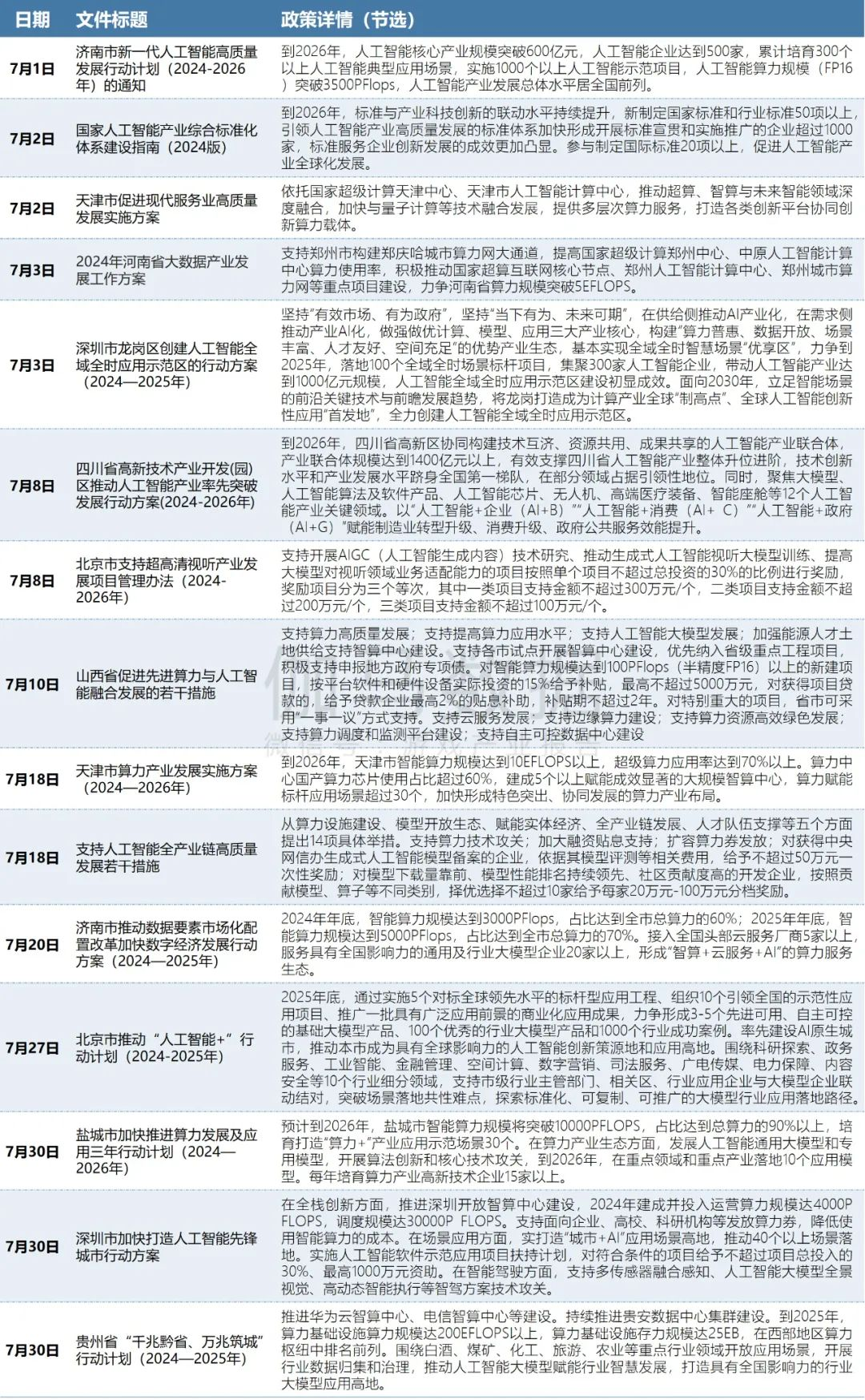

伽马AI月报:7款国内产品进入全球TOP100,Meta AI增长超65%

伽马AI月报:7款国内产品进入全球TOP100,Meta AI增长超65%AI产品整体流量合计超过50亿,环比降低7.87%,Chat助手类产品流量占据57.74%。

AI产品整体流量合计超过50亿,环比降低7.87%,Chat助手类产品流量占据57.74%。

Meta似乎也已经意识到,当下最好的选择是授人以渔。

Llama 3.1刚发布不久,Llama 4已完全投入训练中。 这几天,小扎在二季度财报会上称,Meta将用Llama 3的十倍计算量,训练下一代多模态Llama 4,预计在2025年发布。

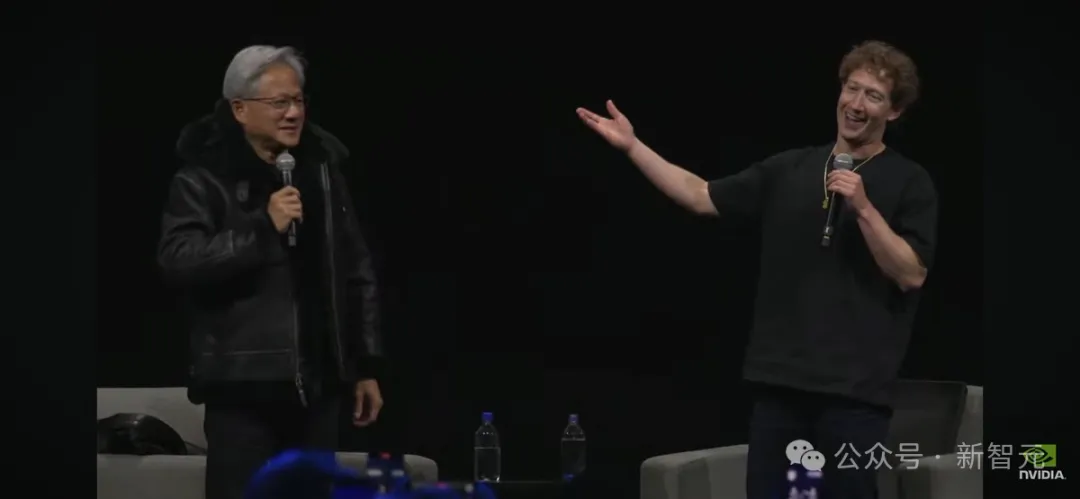

『RAG 高效应用指南』系列将就如何提高 RAG 系统性能进行深入探讨,提供一系列具体的方法和建议。同时读者也需要记住,提高 RAG 系统性能是一个持续的过程,需要不断地评估、优化和迭代。

还记得 Meta 的「分割一切模型」吗?这个模型在去年 4 月发布,被很多人认为是颠覆传统 CV 任务的研究。

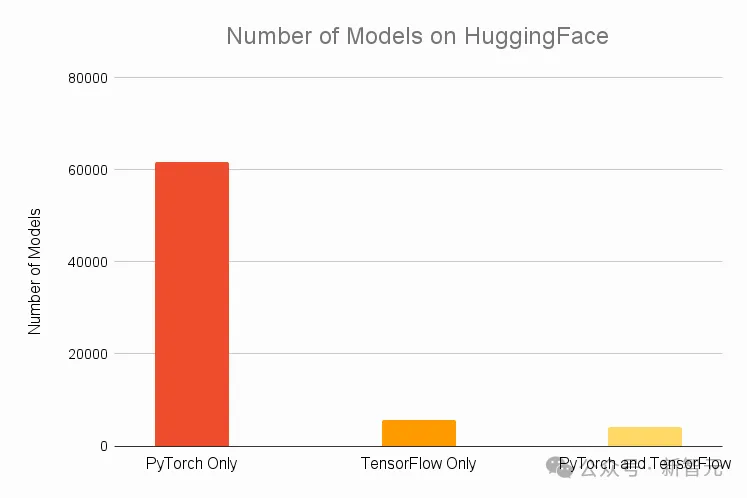

最近,PyTorch团队首次公布了开发路线图,由内部技术文档直接修改而来,披露了这个经典开源库下一步的发展方向。

Meta目前专注于通过参与度实现盈利

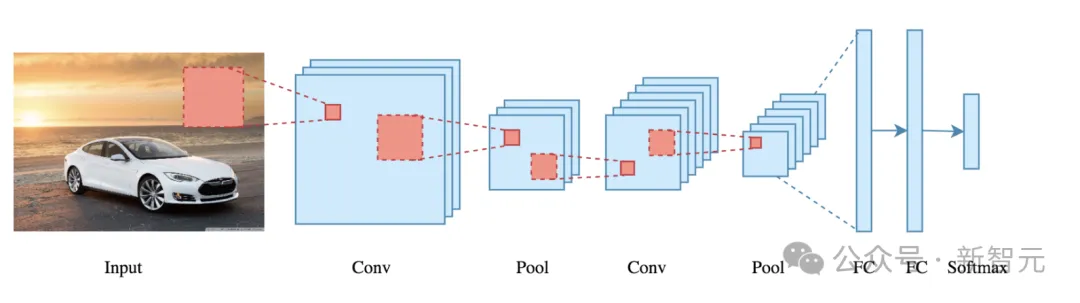

下一代视觉模型会摒弃patch吗?Meta AI最近发表的一篇论文就质疑了视觉模型中局部关系的必要性。他们提出了PiT架构,让Transformer直接学习单个像素而不是16×16的patch,结果在多个下游任务中取得了全面超越ViT模型的性能。

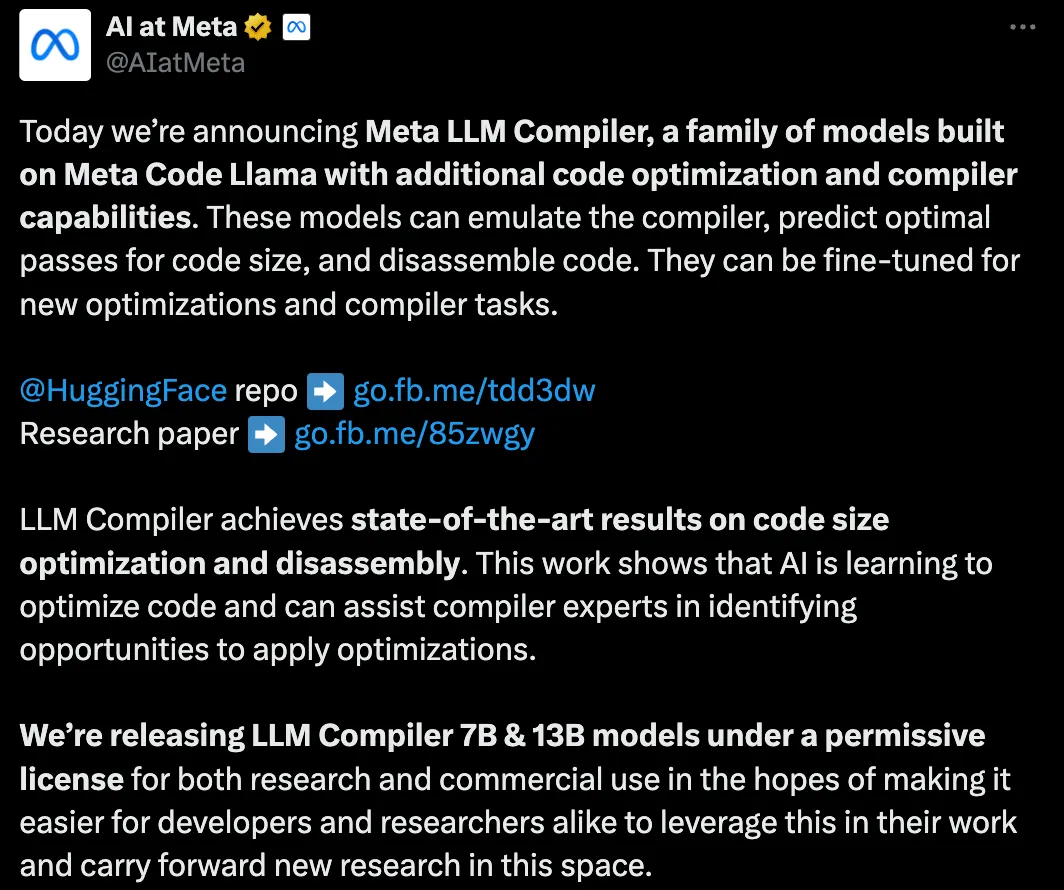

Meta搞了个很牛的LLM Compiler,帮助程序员更高效地写代码。

Meta AI的NLLB-200登上Nature,「不让任何一门语言掉队」,能翻译200种语言的大模型获得Nature社论的盛赞——复兴了濒临灭绝的语言,但是Nature研究人员也郑重提醒Meta,必须将使用这些语言的社区也纳入进来,才会真正减缓语言的消亡。